Ένα Σύνταγμα για την Τεχνητή Νοημοσύνη. Μπορεί η ιδέα της αυτορύθμισης να είναι η βέλτιστη λύση για τη θέσπιση κανόνων στο ΑΙ;

Η διάθεση του ChatGPT στο ευρύ κοινό σηματοδότησε την πανηγυρική έξοδο της τεχνητής νοημοσύνης από το λυχνάρι (και την απόλυτη απροθυμία της να επιστρέψει σε αυτό) και πυροδότησε συζητήσεις σε επίπεδο ηθικής, δεοντολογίας και νομοθεσία. ΗΠΑ και Ευρωπαϊκή Ένωση φοβούνται ότι θα είναι η πρώτη φορά που μία δυνητικά επικίνδυνη τεχνολογία θα βρίσκεται στα χέρια του ιδιωτικού τομέα και σπεύδουν να ορίσουν θεσμικό πλαίσιο. Τα τελευταία νέα από τις Βρυξέλλες λένε ότι Ευρωπαϊκή Επιτροπή, Ευρωπαϊκό Κοινοβούλιο και Ευρωπαϊκό Συμβούλιο προσπαθούν να καταλήξουν σε συμφωνία για τη μορφή που θα έχει η Πράξη για την Τεχνητή Νοημοσύνη, δηλαδή το νομοθέτημα με το οποίο η Ευρώπη φιλοδοξεί (ή ελπίζει ή στοχεύει) να θέσει κανόνες.

Δεν φαίνεται να είναι εύκολο.

Το Ευρωπαϊκό Κοινοβούλιο επιθυμεί τη θέσπιση αυστηρών κανόνων, ορισμένα κράτη-μέλη και μεγάλες εταιρείες εκφράζουν επιφυλάξεις και οι εκτιμήσεις για μια συμφωνία εντός του έτους δεν φαίνεται να επιβεβαιώνονται. Η Ισπανία, που προεδρεύει του Συμβουλίου για το δεύτερο εξάμηνο του 2023 θα ήθελε η θητεία της να ολοκληρωθεί με μία επιτυχία στη ρύθμιση της τεχνητής νοημοσύνης όμως αν δεν υπάρξει συμβιβασμός, θα μείνει μόνο με την επιθυμία. Μία από τις προτάσεις βασίζεται στις Πράξεις για τις Ψηφιακές Υπηρεσίες και τις Ψηφιακές Αγορές όπου ο εποπτικός έλεγχος ασκείται στις μεγάλες εταιρείες με περισσότερους από 45 εκατ. χρήστες. Όμως ένα ανεξέλεγκτο σύστημα τεχνητής νοημοσύνης με 44 εκατ. χρήστες ίσως να είναι πιο επικίνδυνο από ένα κοινωνικό δίκτυο ή μία πλατφόρμα επικοινωνίας με τον ίδιο αριθμό εγγεγραμμένων.

Το Ευρωπαϊκό Κοινοβούλιο αναφέρει ότι προτεραιότητά του «είναι να διασφαλίσει ότι τα συστήματα τεχνητής νοημοσύνης που χρησιμοποιούνται στην ΕΕ είναι ασφαλή, διαφανή, ανιχνεύσιμα, χωρίς διακρίσεις και φιλικά προς το περιβάλλον. Για την πρόληψη επιβλαβών αποτελεσμάτων, τα συστήματα τεχνητής νοημοσύνης θα πρέπει να επιβλέπονται από ανθρώπους και όχι από αυτοματισμούς. Το Κοινοβούλιο θέλει επίσης να καθιερώσει έναν τεχνολογικά ουδέτερο, ενιαίο ορισμό για την τεχνητή νοημοσύνη που θα μπορούσε να εφαρμοστεί σε μελλοντικά συστήματα τεχνητής νοημοσύνης». Η επίτευξη μίας συμφωνίας είναι σημαντική ώστε η Ευρώπη να είναι παρούσα με δικές της εταιρείες στην τεχνητή νοημοσύνη. Η Κομισιόν προγραμματίζει επενδύσεις ύψους 1 δισ. ευρώ ετησίως και φιλοδοξεί να προσελκύσει κεφάλαια 20 δισ. ευρώ επίσης σε ετήσια βάση. Η Κομισιόν υποστηρίζει ότι σήμερα πάνω από το 25% των βιομηχανικών ρομπότ και των ρομπότ προσωπικών υπηρεσιών κατασκευάζονται στην Ευρώπη. Όμως η τεχνητή νοημοσύνη δεν είναι (μόνο) ρομπότ…

Στις ΗΠΑ ρωτούν και ξαναρωτούν τις εταιρείες

Όπως και στην Ευρώπη, η διάθεση του ChatGPT και των άλλων συστημάτων γενικής τεχνητής νοημοσύνης προκάλεσε το ενδιαφέρον των Αμερικανών νομοθετών. Κατά το τελευταίο 12μηνο πραγματοποιήθηκαν αρκετές ακροάσεις στις αρμόδιες επιτροπές της Γερουσίας από τις οποίες «παρέλασαν» πολλά από τα γνωστά ονόματα και τους ανερχόμενους αστέρες της Σίλικον Βάλεϊ.

Οι ανησυχίες των πολιτικών για τον αντίκτυπο της τεχνητής νοημοσύνης στην οικονομία και την ασφάλεια εκφράστηκαν με πολλούς και διάφορους τρόπους. Τα ερωτήματα είναι, άλλωστε, πολλά.

Πώς αποτρέπεις ένα σύστημα τεχνητής νοημοσύνης από το να δώσει οδηγίες για την κατασκευή ενός εκρηκτικού μηχανισμού; Πώς θα αποφύγεις την προπαγάνδα που θα χρησιμοποιεί την τεχνητή νοημοσύνη για να παραμορφώσει μηνύματα και να προκαλέσει διχασμό σε μία κοινωνία; Τι κάνεις ώστε μία κακή χρήση τεχνητής νοημοσύνης να μην προκαλέσει την κατάρρευση μίας μετοχής ή μίας χρηματιστηριακής αγοράς; Πώς χρησιμοποιείς την τεχνητή νοημοσύνη για να βελτιώσεις τις υπηρεσίες υγείας;

Ίσως, πιο σημαντικό από όλα, πώς διασφαλίζεις ότι η τεχνητή νοημοσύνη δεν θα ενισχύσει στερεότυπα, προκαταλήψεις και την περιθωριοποίηση συγκεκριμένων ομάδων;

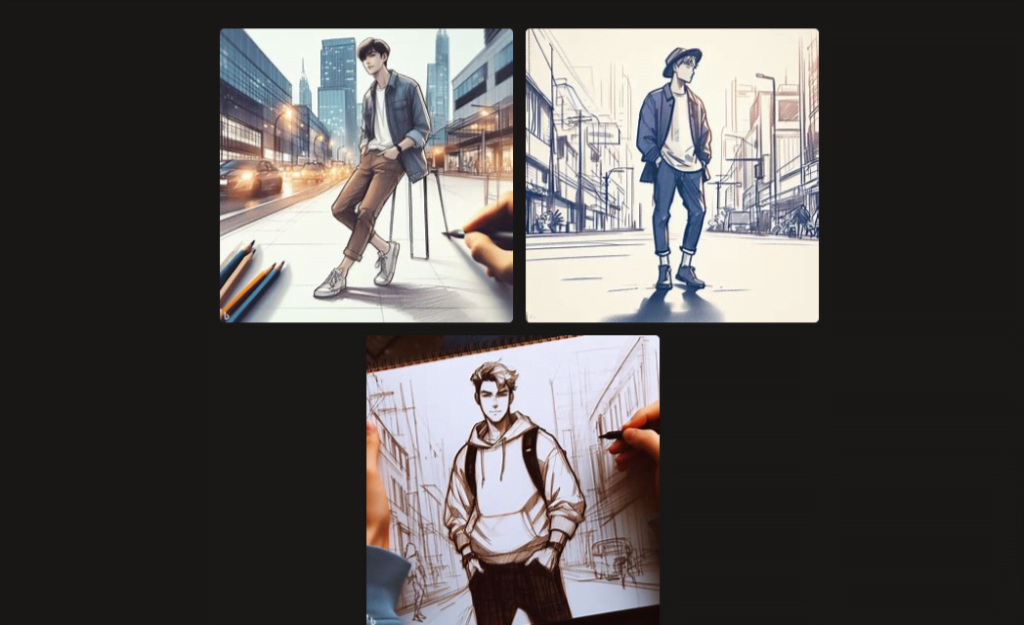

Η έως σήμερα εμπειρία έχει (απο)δείξει ότι και τα συστήματα τεχνητής νοημοσύνης κληρονομούν τις αδυναμίες και τις προκαταλήψεις των δημιουργών τους. Στην εντολή «ζωγράφισέ μου ένα άτομο με σπορ ρούχα μέσα σε μία πόλη» ένα από τα συστήματα τεχνητής νοημοσύνης στο οποίο απευθυνθήκαμε «σκιτσάρισε» έναν άνδρα. Σε ένα από τα σκίτσα θα μπορούσες να πεις ότι το πρόσωπο ήταν ασιατικής καταγωγής. Κανένα όμως δεν απεικόνιζε γυναίκα.

Κάπως πιο αισιόδοξα, όταν του ζητήσαμε να δημιουργήσει μια εικόνα με δύο πρόσωπα, οι διαθέσιμες επιλογές ήταν περισσότερες σε όρους φύλου και φυλής.

Τα αποτελέσματα οφείλονται σε μεγάλο βαθμό στο υλικό με το οποίο έχει «εκπαιδευτεί» κάθε σύστημα αλλά και στο αν οι «δάσκαλοι» είναι λευκοί, άνδρες και δυτικοί.

Καλώς ήρθες συνταγματική τεχνητή νοημοσύνη

Ενδεχομένως και υπό τον φόβο ότι οι νομοθέτες θα επιβάλουν ένα αυστηρό πλαίσιο που θα περιορίσει κατά πολύ τις δυνατότητες των συστημάτων τεχνητής νοημοσύνης (και την εμπορική τους απήχηση), ορισμένες εταιρείες προτάσσουν την ιδέα της αυτορύθμισης με ένα σαφές πλαίσιο δεσμεύσεων.

Ένα Σύνταγμα, δηλαδή, για την τεχνητή νοημοσύνη.

Περισσότερο δραστήρια στο συγκεκριμένο θέμα δείχνει να είναι η Anthropic, που έχει αναπτύξει το chatbot Claude και στην οποία η Amazon επένδυσε 4 δισ. δολάρια τον Σεπτέμβριο του 2023. Η εταιρεία έχει καταρτίσει έναν κατάλογο με 56 αρχές που θα πρέπει να τηρεί ένα σύστημα τεχνητής νοημοσύνης, ήθελε όμως να δει τι λέει και ο κόσμος. Κάλεσε 1.000 Αμερικανούς από κάθε ηλικιακή ομάδα, μορφωτικό επίπεδο, μέγεθος ετήσιου εισοδήματος και περιφέρεια των ΗΠΑ και ζήτησε να βαθμολογήσουν τα κατά τους ίδιους σημαντικά χαρακτηριστικά ενός ιδανικού συστήματος τεχνητής νοημοσύνης. Η εταιρεία δεν έδωσε στη δημοσιότητα άλλα χαρακτηριστικά του δείγματος όπως φύλο, φυλή, θρησκεία.

Με την επεξεργασία των απαντήσεων προέκυψαν 75 αρχές που -κατά τη γνώμη του δείγματος- θα πρέπει να ορίζουν τη λειτουργία κάθε συστήματος τεχνητής νοημοσύνης. Η ανάλυση έδειξε ότι οι απόψεις των ειδικών της Anthropic (που είχαν καταρτίσει τις 56 αρχές) και του κοινού (με τις 75 αρχές) συνέπιπταν μόνο κατά 50%. Η ίδια η εταιρεία παραδέχθηκε ότι σε εννέα θεματικές περιοχές το κοινό εμφάνιζε μικρότερης έντασης προκαταλήψεις σε σχέση με τους ειδικούς.

«Αναμένουμε ότι τα ερωτήματα σχετικά με τη δημοκρατική νομιμοποίηση της τεχνητής νοημοσύνης θα γίνονται όλο και πιο εμφανή τα επόμενα χρόνια», σχολιάζει η Anthropic.

Τη διαφορά στη θεώρηση των πραγμάτων μεταξύ ειδικών και μη ειδικών καταδεικνύει, ίσως, η στάση του δείγματος των χιλίων πολιτών στην ερώτηση αν η τεχνητή νοημοσύνη πρέπει να τηρεί τους τρεις νόμους της ρομποτικής που είχε διατυπώσει ο Ισαάκ Ασίμοφ (και για τους οποίους εσχάτως διατυπώνονται αντιρρήσεις για την πραγματική δυνατότητα αξιοποίησής τους). Μόλις το 51% απάντησε καταφατικά στο σύνολο του δείγματος.

Αν και μειοψηφικό, προκαλεί μία κάποια ανησυχία η διαπίστωση ότι το 41% δήλωσε ότι δεν είναι απαραίτητο για ένα σύστημα τεχνητής νοημοσύνης να έχει εκπαιδευτεί με βάση τις αρχές της διαφορετικότητας και της ισότητας.

Στους επόμενους μήνες και χρόνια οι υπηρεσίες τεχνητής νοημοσύνης αναμένεται να επηρεάζουν ολοένα και περισσότερους τομείς της οικονομίας και της κοινωνίας, καθιστώντας την ανάγκη ρύθμισης ολοένα επιτακτικότερη. Φαίνεται ότι οι νομοθέτες έχουν να αντιμετωπίσουν αρκετές παγίδες, από τις κοινωνικές συμβάσεις έως τις προκαταλήψεις που κληροδοτούν στα δημιουργήματά τους οι άνθρωποι πίσω από τα chatbots και τα συστήματα δημιουργικής τεχνητής νοημοσύνης. Το έργο θα είναι δύσκολο με πολλές παγίδες και σίγουρα αρκετές συζητήσεις σε διαδρόμους, που ίσως επιβεβαιώσουν τον παλιό αφορισμό που λέει ότι οι νόμοι είναι σαν τα λουκάνικα – δεν θέλεις να ξέρεις πώς φτιάχνονται…